Cette semaine, j’étais avec des managers travaillant dans plusieurs collectivités territoriales et avec un grand groupe dans le secteur des finances.

Une phrase revient sans cesse : nous n’allons plus réfléchir avec les IA.

Voilà ce que je rappelle dans mes interventions :

La quête de l’IA dans les organisations n’est pas une simple course à la performance (comme j’entends beaucoup), mais pour les utilisateurs ou les décideurs, savoir distinguer la reconnaissance de motifs statistiques avec un raisonnement logique.

Et cela vient du fait que beaucoup d’utilisateurs ne comprennent pas la cognition artificielle, ni les différents modes de raisonnement humain.

Pour saisir les limites actuelles de l’IA, il faut comprendre que l’intelligence humaine jongle avec trois modes de raisonnement distincts.

Les raisonnements déductif, inductif et abductif de l’humain et de l’IA

Le premier, le raisonnement déductif, est la mécanique implacable de la logique, allant du général au particulier. C’est un raisonnement de type mathématique où, si les prémisses sont vraies, la conclusion l’est nécessairement.

Les ordinateurs y excellent, car c’est le fondement même de leur programmation.

Le second, le raisonnement inductif, procède à l’inverse : il part d’observations spécifiques pour généraliser et identifier des tendances. C’est le moteur du Machine Learning, qui analyse des millions d’exemples pour prédire le suivant.

Mais le troisième, le raisonnement abductif, est le talon d’Achille de l’IA. Il s’agit de formuler l’explication la plus plausible à partir d’informations incomplètes, de générer une « supposition éclairée » face à l’ambiguïté.

C’est l’essence de ce que nous nommons l’« intuition » ou le « bon sens ». Si les IA maîtrisent de mieux en mieux la déduction et l’induction, elles sont démunies face à l’abduction.

Elles identifient des motifs, mais peinent à saisir le sens qui les sous-tend ou à formuler des hypothèses pertinentes dans des situations inédites. On appelle cela un raisonnement abductif.

Le raisonnement neurosymbolique de l’IA

La tendance actuelle est de fusionner deux raisonnement. L’objectif des modèles hybrides en IA, dits « neurosymboliques », est une réponse directe au défi du bon sens : il s’agit d’injecter du raisonnement logique et des connaissances structurées dans la puissance d’apprentissage des réseaux de neurones. Concrètement, cela peut consister à incorporer des règles métiers connues (des contraintes physiques ou réglementaires, par exemple) directement dans un réseau de neurones. Cela permet non seulement d’améliorer ses performances et de réduire la quantité de données nécessaires à son entraînement, mais surtout de s’assurer que ses prédictions restent dans un cadre logique et compréhensible.

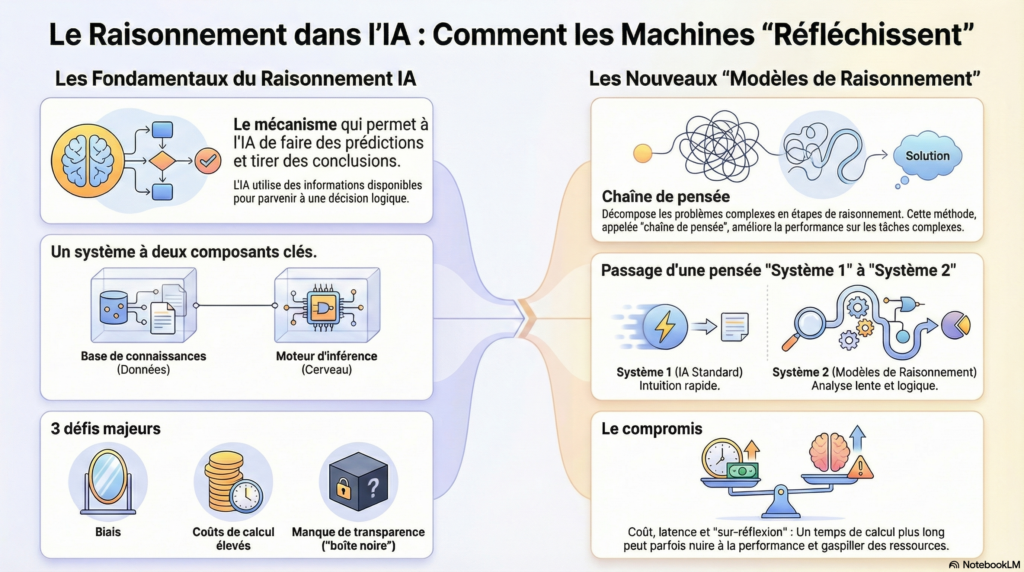

Si les modèles neurosymboliques modifient l’architecture de l’IA pour y intégrer la logique, une autre stratégie s’attaque à son processus de décision au moment même de l’inférence.

Cette approche s’inspire directement des travaux du psychologue et prix Nobel Daniel Kahneman sur les deux modes de la pensée humaine.

Les systèmes 1 et 2 de Kahneman reproduits par l’IA

Kahneman décrit un Système 1, rapide, automatique et intuitif, qui nous permet de reconnaître un visage ou de comprendre une phrase simple sans effort. Il décrit également un Système 2, lent, délibéré et logique, que nous mobilisons pour résoudre un problème complexe.

Or, les grands modèles de langage (LLM) fonctionnent par défaut comme un Système 1 surpuissant. Ils génèrent des réponses de manière quasi instantanée en prédisant le mot suivant le plus probable, ce qui explique leur fluidité mais aussi leur tendance aux erreurs factuelles, aux incohérences et aux « hallucinations ».

Pour surmonter cette impulsivité, les chercheurs ont développé de nouveaux « modèles de raisonnement ». Plutôt que de fournir une réponse directe, ces IA sont entraînées à générer d’abord des étapes de raisonnement intermédiaires. Elles apprennent à « montrer leur travail », à verbaliser une chaîne de pensée avant de conclure. Cette méthode, qui consiste à utiliser plus de calcul au moment de la réponse pour explorer et affiner les sorties possibles, simule une forme de pensée Système 2.

En rendant le « chemin de pensée » de la machine explicite et inspectable, nous pouvons enfin commencer à vérifier, déboguer et « faire confiance » à ses conclusions. Qu’elle soit obtenue par une nouvelle architecture ou un nouveau processus, cette quête d’une IA plus délibérée est une étape cruciale vers des systèmes plus robustes et fiables.

Mais supposons que nous parvenions à combler le fossé du raisonnement abductif, à créer une IA logique, transparente et délibérée. Une dernière frontière, plus fondamentale, séparerait encore la cognition artificielle de la conscience humaine.

Ce qui manque à l’IA, c’est ce que nous éprouvons

Le raisonnement humain ne se fonde pas uniquement sur des données brutes ; il puise dans une « base de données mémorielle » qui, comme le souligne la chercheuse Marcienne Martin, est intrinsèquement liée à notre corps, à nos expériences vécues (le vécu), et à notre « champ émotionnel ».

L’IA, elle, est construite sur une base de données informationnelle extraite de structures socioculturelles — l’intégralité d’Internet, par exemple — mais ce substrat est désincarné. Pour reprendre la formule de Martin, « la base de données de l’intelligence artificielle prend sa source d’une structure groupale inscrite dans un substrat socioculturel spécifique au sein duquel le champ émotionnel n’est pas activé. »

Cette absence a des conséquences profondes sur la créativité. Une IA peut certes gagner un concours d’art, comme ce fut le cas pour l’œuvre Théâtre D’opéra Spatial, mais le processus créatif est d’une nature radicalement différente. L’art humain est souvent nourri par l’intentionnalité et le vécu, parfois de manière indirecte et poignante. Elle simule la créativité, mais ne la vit pas.

Une des priorités pour l’humain est de se réapproprier son raisonnement

Alors que nous cherchons à construire des IA qui nous ressemblent, nous découvrons que la quête la plus importante n’est peut-être pas celle de l’intelligence artificielle, mais bien celle d’une meilleure compréhension de la nôtre… Et là où il y a encore un peu de travail à faire auprès des utilisateurs que nous sommes…